Duplicate content to powielone treści występujące w różnych miejscach w sieci. Do usuwania zduplikowanych treści stosuje się: przekierowania 301, znaczniki canonical, blokowanie dostępu przez robots.txt, noindex oraz deindeksację stron. Pozwala to uniknąć kar od Google i konkurowania treści ze sobą. Duplikaty mogą powstawać przez: system CMS, parametry URL, błędy techniczne.

Zduplikowane treści stanowią poważne wyzwanie dla właścicieli stron internetowych i specjalistów SEO. Problem duplikacji może mocno wpływać na pozycjonowanie witryny w wyszukiwarkach, dlatego konieczne jest systematyczne monitorowanie i eliminowanie powtarzających się materiałów. Skuteczne rozwiązywanie problemu duplikacji wymaga zastosowania profesjonalnych narzędzi i metodologii: od prostych programów porównujących tekst po zaawansowane rozwiązania wykorzystujące algorytmy sztucznej inteligencji. Można zauważyć, że duplikaty mogą występować także wewnątrz jednej domeny (duplikacja wewnętrzna)i pomiędzy różnymi witrynami (duplikacja zewnętrzna). Zasadnicze jest wdrożenie odpowiednich procedur już na etapie tworzenia treści – pomoże to uniknąć późniejszych problemów z optymalizacją.

Zaawansowane metody detekcji zduplikowanych treści

Aktualnie narzędzia do wykrywania duplikatów wykorzystują różnorodne techniki analizy – od prostego porównywania ciągów znaków po skomplikowane algorytmy semantyczne. Implementacja wydajnego systemu detekcji wymaga uwzględnienia następujących elementów:

- Analiza podobieństwa leksykalnego

- Weryfikacja struktury tekstu

- Sprawdzanie unikalności metadanych

- Monitoring kanonikalności URL

- Badanie spójności treści

Profesjonalne rozwiązania do eliminacji duplikatów muszą uwzględniać kontekst biznesowy i specyfikę branży. Platformy e-commerce często borykają się z problemem podobnych opisów produktów, podczas gdy serwisy informacyjne muszą uważać na powielanie newsów. „Ważne jest zrozumienie, że nie każda powtarzająca się treść stanowi problem SEO” – to fundamentalna zasada optymalizacji. Wykorzystanie technik dezambiguacji i tokenizacji pozwala na precyzyjne określenie stopnia podobieństwa tekstów.

Optymalizacja i zarządzanie treścią

W procesie eliminacji duplikatów warto skupić się na implementacji długofalowej strategii zarządzania contentem. Systematyczna deduplication powinna obejmować częste audyty i monitoring występowania potencjalnych powtórzeń. Zastosowanie znaczników kanonicznych (canonical tags) oraz prawidłowa konfiguracja robots.txt to podstawowe elementy technicznej optymalizacji. Czy wdrożenie automatyzacji w tym procesie jest zawsze najlepszym rozwiązaniem? Praktyka pokazuje, że najlepsze jest dobranie automatycznych narzędzi z ludzką weryfikacją (szczególnie w przypadku treści specjalistycznych i branżowych). „Właściwe zarządzanie duplikatami wymaga holistycznego podejścia” – to ważny aspekt nowoczesnego SEO.

Jak dobrze pozbyć się duplikacji treści i uratować SEO swojej strony?

Zduplikowane treści to prawdziwa zmora pozycjonowania i jeden z głównych problemów występujących na stronach internetowych. Google nie lubi widzieć tych samych tekstów w wielu miejscach, ponieważ nie wie, którą wersję uznać za właściwą. Ważnym krokiem do rozwiązania problemu jest przeprowadzenie dokładnej analizy witryny pod kątem występowania powtarzających się fragmentów. Możemy wykorzystać do tego narzędzia takie jak Screaming Frog czy Siteliner. Następnie należy podjąć odpowiednie działania naprawcze, które mogą obejmować użycie znacznika canonical, przekierowania 301 czy modyfikację treści.

Zasadnicze jest zwrócenie uwagi na duplikacje powstające w wyniku różnych wariantów URL prowadzących do tej samej strony. Problem często dotyka sklepów internetowych, gdzie ten sam produkt może być dostępny pod różnymi adresami ze względu na filtry, parametry czy kategorie. W takich przypadkach podstawowe jest właściwe zastosowanie znacznika rel=”canonical”, który wskaże wyszukiwarkom preferowaną wersję strony.

Można też zadbać o unikalność opisów produktów, kategorii i treści na stronie. To może być czasochłonne, ale przynosi najlepsze efekty w długim okresie. Częste monitorowanie występowania duplicate content pomoże szybko reagować na nowe przypadki duplikacji. Pamiętajmy też o właściwej konfiguracji pliku robots.txt oraz mapy strony, co ułatwi robotom indeksującym prawidłowe poruszanie się po witrynie.

Duplikat treści w SEO – kiedy Google uderza z całą mocą?

Wykrycie zduplikowanych treści przez algorytmy Google może skutkować poważnymi konsekwencjami dla pozycjonowania witryny. Wyszukiwarka nakłada kary na strony, które mają skopiowane lub bardzo podobne treści, także w obrębie własnego serwisui z innych źródeł. Spadek pozycji w wynikach wyszukiwania to tylko początek problemów. Google może także ograniczyć indeksację strony lub całkowicie usunąć ją z wyników. Szczególnie rygorystycznie traktowane są przypadki, gdy duplikacja obejmuje znaczną część witryny.

- Automatyczne filtrowanie przez algorytm

- Spadek pozycji w SERP

- Ograniczenie indeksacji

- Usunięcie z wyników wyszukiwania

- Utrata wartości linków przychodzących

- Zmniejszenie ruchu organicznego

- Wydłużony proces przywracania pozycji

Proces wykrywania duplikatów przez Google staje się zaawansowany. Wyszukiwarka potrafi zidentyfikować identyczne treści, a także te, które zostały nieznacznie zmodyfikowane. Kara może dotknąć także stronę źródłowąi tę mającą skopiowaną treść, jeśli Google nie będzie w stanie jednoznacznie określić, która wersja jest oryginalna.

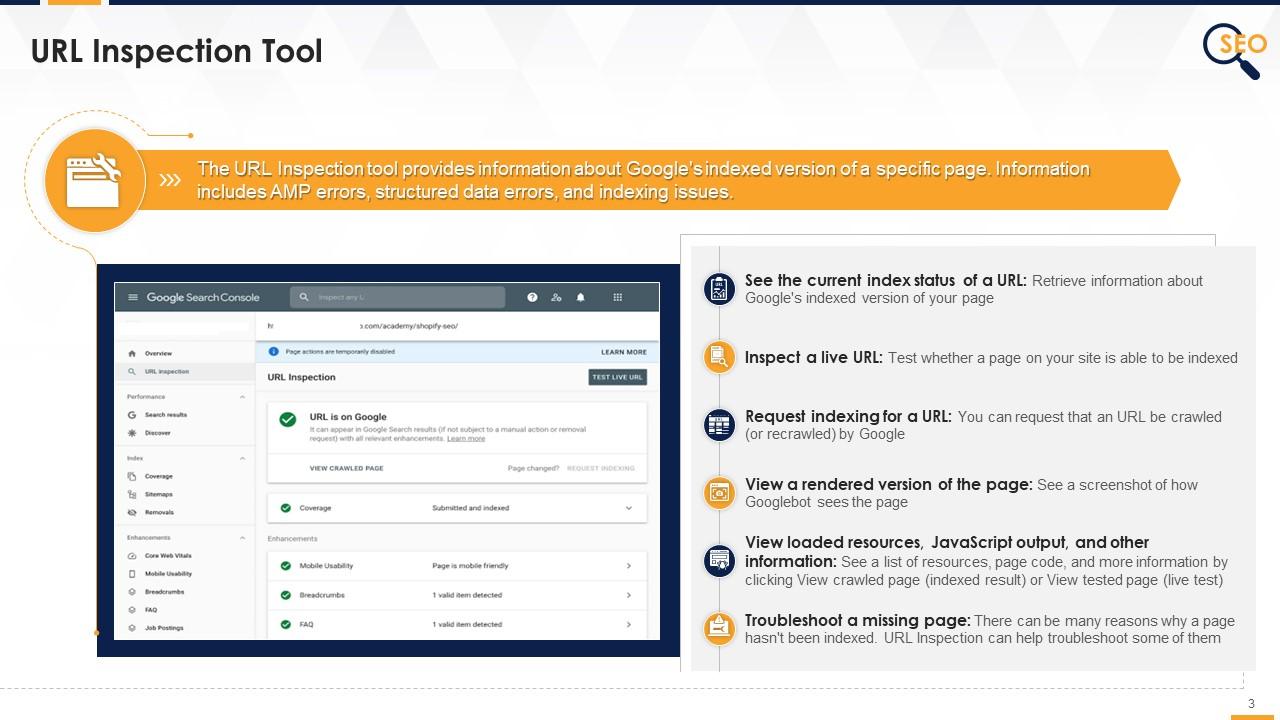

Canonicalization jako metoda unikania kar za duplikaty

Implementacja znaczników canonical to jedna z najbardziej efektywnych metod zapobiegania karom za zduplikowane treści. Pozwala ona wskazać wyszukiwarce, która wersja strony powinna być traktowana jako główna. Jest to ważne w przypadku sklepów internetowych, gdzie te same produkty mogą pojawiać się w różnych kategoriach, generując naturally occurring duplicates.

Wśród narzędzi do wykrywania zduplikowanych treści uwagę należy zwrócić na Copyscape Premium, który jest uznawany za jeden z najdokładniejszych detektorów plagiatu w sieci. Narzędzie to umożliwia sprawdzanie pojedynczych tekstów, masowe skanowanie całych witryn pod kątem duplikatów. Siteliner to kolejne zaawansowane rozwiązanie, które koncentruje się na wykrywaniu wewnętrznych duplikatów w obrębie jednej domeny. Szczególnie przydatne jest to dla właścicieli rozbudowanych serwisów internetowych, którzy chcą uniknąć kanibalizacji słów ważnych. Duplichecker oraz Plagiarism Checker X dają bardziej zaawansowane funkcje, takie jak sprawdzanie podobieństwa tekstu w różnych językach czy możliwość porównywania dokumentów offline. Plagium to narzędzie, które wyróżnia się możliwością sprawdzania treści w czasie rzeczywistym, co jest nieocenione dla redakcji internetowych i agencji contentowych. Small SEO Tools i Quetext to darmowe alternatywy, które sprawdzają się w przypadku okazjonalnych weryfikacji. Search Engine Reports oferuje raporty mające informacje o duplikatach, sugestie dotyczące optymalizacji treści. Grammarly, choć pierwotnie stworzony jako narzędzie do sprawdzania pisowni, ma także funkcję wykrywania plagiatu, która jest szczególnie ceniona przez środowisko akademickie i profesjonalnych copywriterów. Content Detective to dosyć nowe narzędzie, które wykorzystuje zaawansowane algorytmy AI do wykrywania nawet parafrazowanych treści, co czyni go szczególnie skutecznym w walce z bardziej wyrafinowanymi formami duplikacji.